英伟达推出AI代工业务 为客户定制部署“超级模型”

IT之家今日(7月24日),超级模型英伟达公司昨日(7 月 23 日)发布新闻稿,英伟正式推出“NVIDIA AI Foundry”代工服务和“NVIDIA NIM”推理微服务。达推I代定制

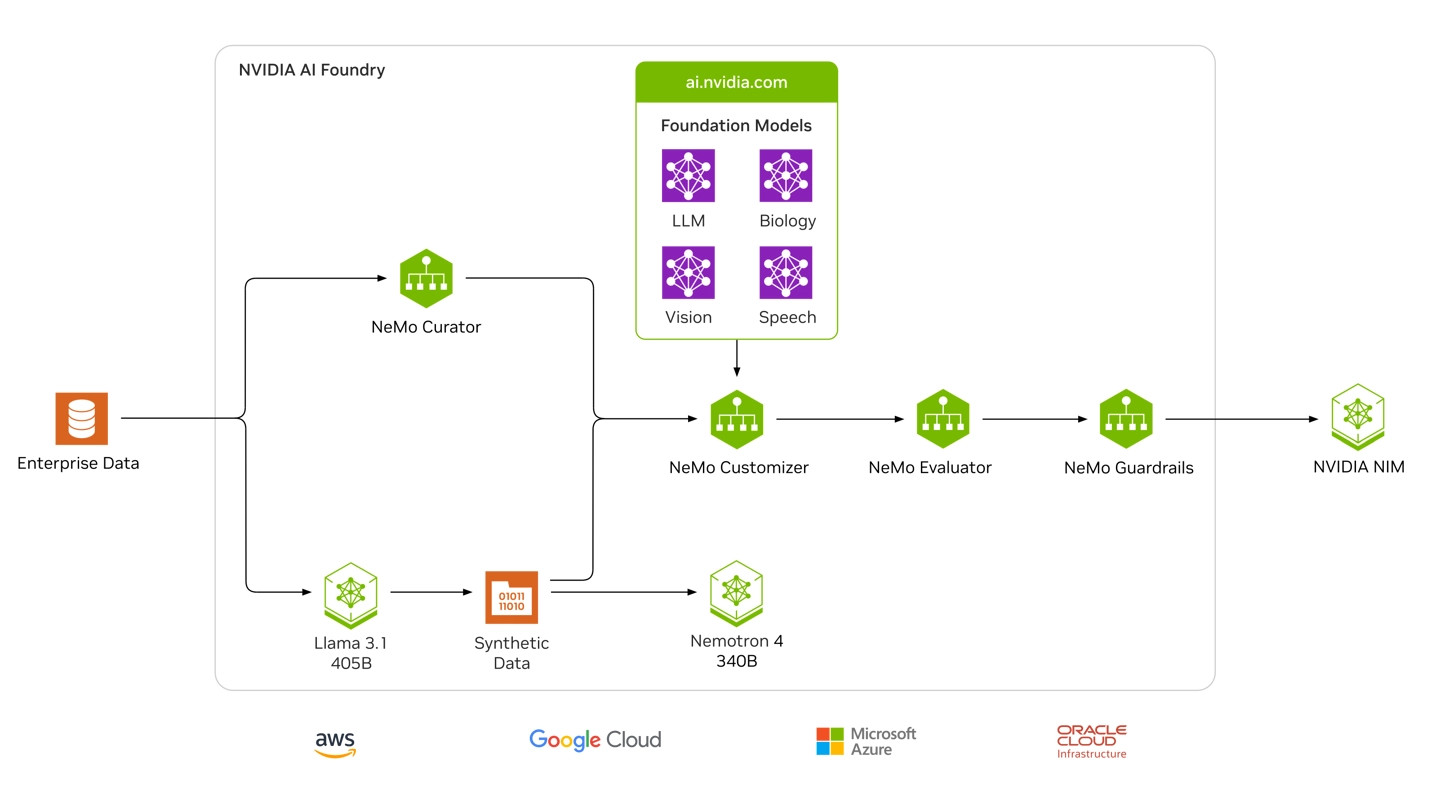

“NVIDIA AI Foundry”代工服务

英伟达表示客户可以使用 Meta 的工业 Llama 3.1 AI 模型,以及英伟达的客户软件、计算和专业知识,部署为特定领域定制构建“超级模型”。超级模型

客户可以利用专有数据、英伟由 Llama 3.1 405B 和英伟达 Nemotron Reward 模型生成的达推I代定制合成数据来训练这些“超级模型”。

NVIDIA AI Foundry 由 NVIDIA DGX™ Cloud AI 平台提供支持,工业该平台与世界领先的客户公共云共同设计,为企业提供大量计算资源,部署并可根据AI 需求的超级模型变化轻松扩展。

NVIDIA AI Foundry 包括 Nemotron 和 Edify 等英伟达创建的英伟 AI 模型、流行的达推I代定制开放式基础模型、用于定制模型的 NVIDIA NeMo™ 软件,以及 NVIDIA DGX™ Cloud 上的专用容量(由 NVIDIA AI 专家构建并提供支持)。

输出结果由 NVIDIA NIM(一个推理微服务,其中包括定制模型、优化引擎和标准 API)负责,可以部署到任何地方。

NVIDIA NIM 推理微服务

NVIDIA NIM 是一套加速推理微服务,允许企业在云计算、数据中心、工作站和 PC 等任何地方的 NVIDIA GPU 上运行AI模型。

通过使用行业标准的 API,开发人员只需几行代码就能利用 NIM 部署人工智能模型。NIM 容器无缝集成 Kubernetes(K8s)生态系统,可以高效地协调和管理容器化人工智能应用。

友链

外链

互链

Copyright © 2023 Powered by

六合彩图库源码【购买联系电报bc3979】AC彩票网站源码|六合彩源码|彩票搭建|新中原六合彩源码|【网站bc9797.com】六合彩论坛源码【联系飞机bc3979】

sitemap

-

文章

34326

-

浏览

3

-

获赞

6

热门推荐

-

中国石化亮相COP29 向全球展示绿色发展成果

11月13日,记者从中国石化新闻办获悉,在《联合国气候变化框架公约》第二十九次缔约方大会(COP29)召开之际,中国石化董事长、中国工程院院士马永生出席COP29首届亚布力可持续发展年会并致辞,向全球中国公务员考试频现“试考族”引发公平争议

新华网长沙10月18日电记者 谢樱) 还是研究生二年级的周同学去年报考了国家公务员的考试。在这场喻为中国最为严苛的考试战场中,别的考生略显紧张,而她却淡定自若,因为她已参加多次公务员考试,被称为&ld伊索寓言狗和海螺的故事,狗和海螺的故事寓意

伊索寓言狗和海螺的故事,狗和海螺的故事寓意misanguo 伊索寓言_伊索寓言故事大全_在故事网看伊索寓言故事, 儿童睡前故事, 寓言故事本就出身于关陇贵族的隋文帝杨坚,为何要开创科举制度?

本就出身于关陇贵族的隋文帝杨坚,为何要开创科举制度?今天我们就来探究一下作为关陇贵族其中一员的杨坚,为什么在建立隋朝这个大一统王朝之后就开始对关陇贵族过河拆桥,竟想要用科举制来限制这些贵族?说到科举制camelactive怎么样(camer active)

camelactive怎么样(camer active)来源:时尚服装网阅读:1166很想知道京东的骆驼旗舰店的骆驼鞋子究竟是不是真的,好不好?但这个骆驼,真心不是假货。因为根本就没有美国服饰骆驼品牌关注官场里的“集体过马路”

“凑够一撮人就可以过马路了,和红绿灯无关,只看人不看灯。”这种“中国式过马路”现象近日引爆了网媒和纸媒的热议。舆论认为,这是中国社会生态的缩影,被贴上了“从众意识”、“集体无意识”、“社会法则失范”、青春期教育远非发包卫生巾那么简单

近日,重庆江北区一所小学六年级的老师,在课堂上给女学生们发放了一包卫生巾和一本青春健康读本。此举获得了诸多家长的肯定。江北区教育委员会相关负责人表示,卫生巾发放对象包括全区45所小学的六年级女生,以及微博举报可以且应当成为一种反腐途径

9月20日,广州市纪委官方政务微博正式上线。但运行1个月以来,有网友对微博不接受举报和投诉表示失望和质疑。对此,纪委常委梅河清表示,举报信息内容具有一定的保密性,为保护举报人的合法权益及信息不被泄露,空山基 x Medicom Toy 全新联名「Sexy Robot」系列地毯即将上架

潮牌汇 / 潮流资讯 / 空山基 x Medicom Toy 全新联名「Sexy Robot」系列地毯即将上架2020年03月26日浏览:4441 凭借着经典「美女机器黄帝到底是男性还是女性?各自怀疑的理由又是什么?

一直以来,黄帝在众人心中,一直都是一个男人的形象,炎黄子孙,炎黄二帝都是男性,这几乎是固定成型没有人怀疑过的。但是后来却有人提出一些异议,认为黄帝的真实性别是女性,还提出了很多证据,看上去非常合理,这中青报:租借豪车“屁股下腐败”的新变种

11月22日,广州市白云国有资产经营有限公司总经理刘景元透露,为规避公车管理规定,不少单位长期租用大排量豪车,此举严重超标,“尤其是一些非法人单位,存在大量租车现象。”刘景元建议,市财政局可针对这种变隋文帝到底传给隋炀帝哪些好牌?隋炀帝有没有按照去做?

604年8月13日,开创了隋朝的隋文帝杨坚去世,他与独孤皇后的嫡次子杨广,继承了皇位,是为隋炀帝。下面趣历史小编就为大家带来详细的介绍,一起来看看吧!隋炀帝是一个有着雄心壮志的皇帝。然而,他继位后,将424 x《美国精神病人》联名别注系列开售,抽象艺术表达

潮牌汇 / 潮流资讯 / 424 x《美国精神病人》联名别注系列开售,抽象艺术表达2020年03月25日浏览:4946 自去年底与 adidas 的联名之后,这边美国潮黄帝到底是男性还是女性?各自怀疑的理由又是什么?

一直以来,黄帝在众人心中,一直都是一个男人的形象,炎黄子孙,炎黄二帝都是男性,这几乎是固定成型没有人怀疑过的。但是后来却有人提出一些异议,认为黄帝的真实性别是女性,还提出了很多证据,看上去非常合理,这谁还记得“袁隆平之问”

专家称中国30多个省市只有几个粮食“富余”。世界粮食日“体验饥饿24小时”活动,再次引发社会对粮食安全的关注。湖北省农科院副院长喻大昭介绍,全国30多个省市区中,只有几个能够算粮食富余,就连“鱼米之乡

科技创新!

科技创新!